Est-ce que l’IA fragilise les principes fondateurs d’internet ?

Pour le journaliste Pierre Yves Bocquet (Epsiloon), le risque est à considérer avec sérieux : « tous les piliers du net sont menacés ».

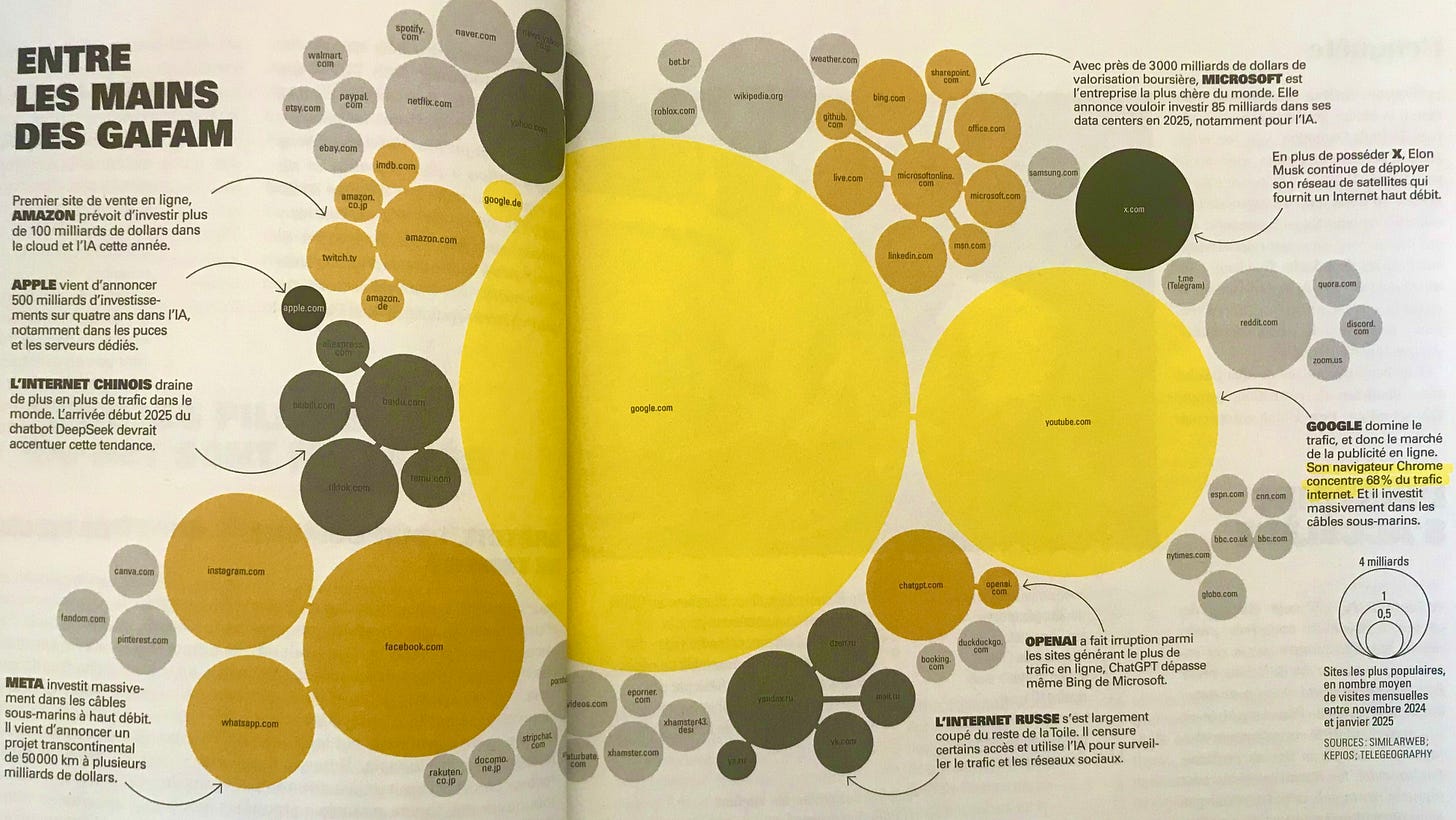

©Espiloon, à partir de Similarweb, Kepios, TeleGeography

Dans une très bonne enquête parue en avril, le journaliste relève au moins 5 grands défis pour internet, à l’ère de la généralisation de l’intelligence artificielle :

Neutralité

Largement contestée par le monopole des GAFAM qui régissent une audience captive malgré le contrôle des institutions, la neutralité du web ressort très fragilisée de la dernière décennie. Comment éviter que la neutralité d’internet pâtisse davantage de plateformes monopolistiques avec l’IA ? Comment éviter qu’internet, main de fer dans un gant de velours, ne soit qu’un prétexte de soft power au service d’États hégémoniques comme les États-Unis ou la Chine ?

Gratuité

L’IA est extrêmement coûteuse. Une requête sur un modèle grand public de LLM est en moyenne 7 fois plus énergivore qu’une requête sur un moteur de recherche classique. Comment réussirons-nous le pari d’un réseau performant et durable ?

Résilience

Notre dépendance croissance aux modèles d’IA nous rend davantage vulnérables à des enjeux de résilience (gestion des dépendances) et de souveraineté (extraterritorialité du droit, tensions géopolitiques, espionnage économique, etc.)

Hypertexte

Pensé dans les années 1960, notamment par Ted Nelson dans le cadre du projet Xanadu, le lien hypertexte sera repris avec grand succès par Tim Berners-Lee en 1989 lors de la conception du World Wide Web. Comment éviter que les chatbot, qui y font très peu recours et souvent avec des erreurs manifestes, mettent les liens hypertextes sous le boisseau et affaiblissent la culture des sources qui y est consubstantielle ?

Mondialisation

Le propre d’internet était sa déterritorialisation. Or, « non seulement le cyberespace est morcelé, mais il participe au cloisonnement du monde. En partie à cause de l’IA et de sa capacité à renforcer le contrôle numérique », estime le chercheur Kevin Limonier (Geode) dans les pages d’Epsiloon.

C’est aujourd’hui, plus que jamais, à la France et à ses partenaires européens de défendre ces valeurs cardinales de nos communs numériques.

Sources

Le numéro 46 d’Epsiloon :

https://www.epsiloon.com/tous-les-numeros/n46/

Les travaux du centre de recherche Géode

https://geode.science/

Les coûts cachés de l’intelligence artificielle

https://www.libraryjournal.com/story/the-environmental-cost-of-ai-climate-crisis